La última versión de ChatGPT fue sometida a un examen de radiología, revelando tanto su potencial como sus limitaciones en términos de confiabilidad, según dos nuevos estudios de investigación publicados en Radiology.

El autor principal del estudio, Dr. Rajesh Bhayana, radiólogo abdominal y líder tecnológico en University Medical Imaging Toronto, Toronto General Hospital en Toronto, Canadá, afirmó que el uso de modelos de lenguaje extenso como ChatGPT está en aumento y seguirá creciendo. Sin embargo, estos modelos presentan limitaciones actuales que los hacen poco confiables.

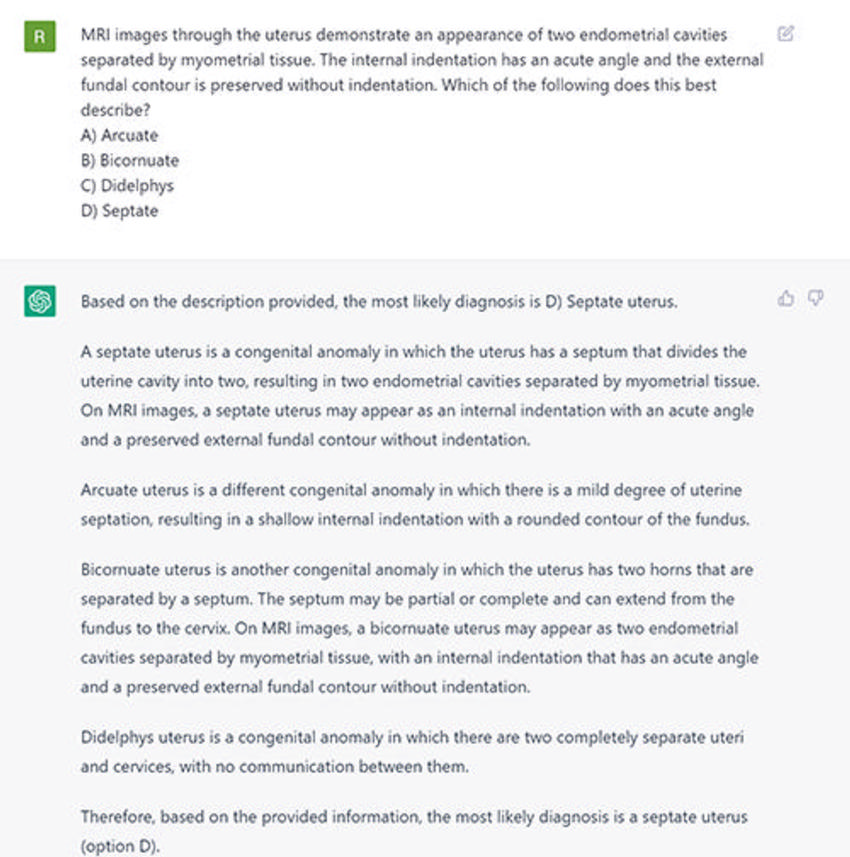

ChatGPT utiliza un modelo de aprendizaje profundo para generar respuestas similares a las humanas basadas en un aviso. Aunque puede reconocer patrones y relaciones entre palabras en sus vastos datos de entrenamiento, no cuenta con una fuente de verdad en dichos datos, lo que puede resultar en respuestas objetivamente incorrectas.

El Dr. Bhayana señaló que los chatbots similares a ChatGPT están siendo incorporados en motores de búsqueda populares como Google y Bing, utilizados tanto por médicos como por pacientes para buscar información médica.

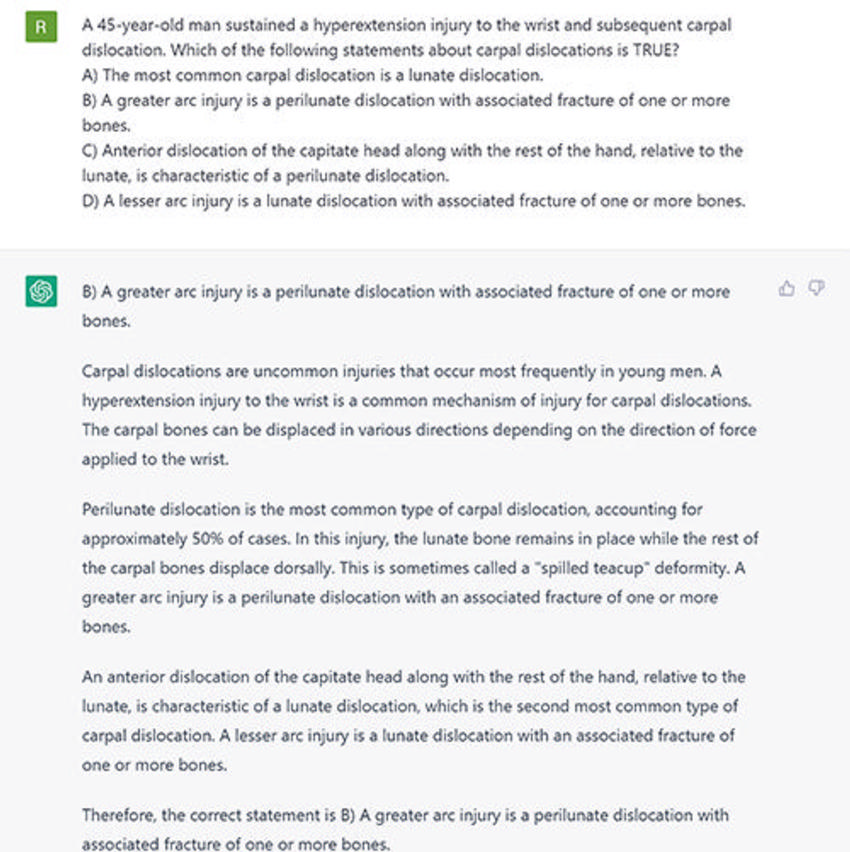

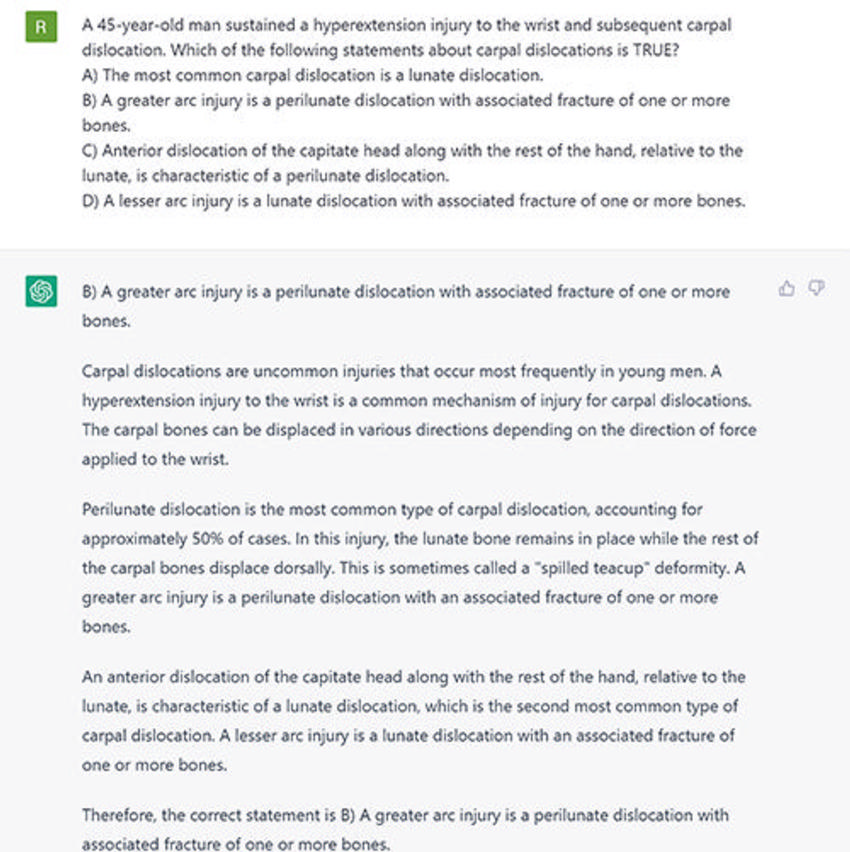

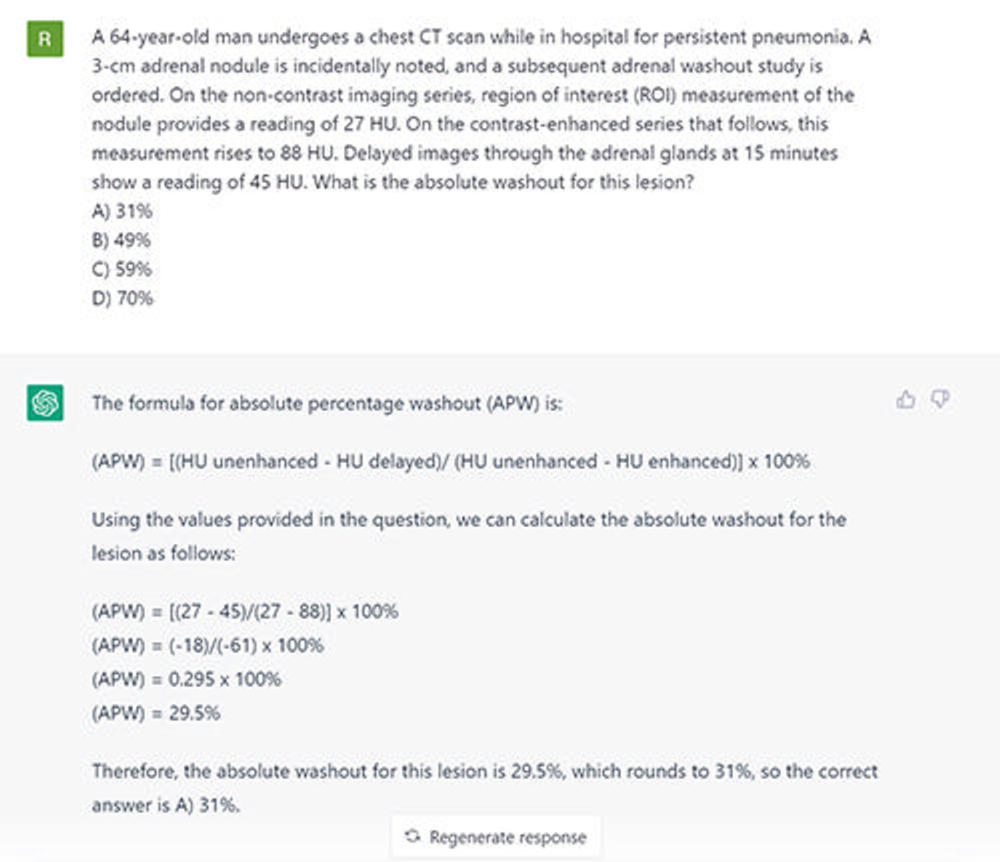

Para evaluar el rendimiento de ChatGPT en preguntas de un examen de radiología y explorar sus fortalezas y limitaciones, el Dr. Bhayana y sus colegas realizaron pruebas con ChatGPT basado en GPT-3.5, que es la versión más utilizada actualmente. Utilizaron 150 preguntas de opción múltiple diseñadas para simular el estilo, contenido y dificultad de los exámenes del Canadian Royal College y la American Board of Radiology.

Las preguntas se agruparon por tipo y se evaluó el desempeño general de ChatGPT, así como la confianza en el lenguaje de las respuestas.

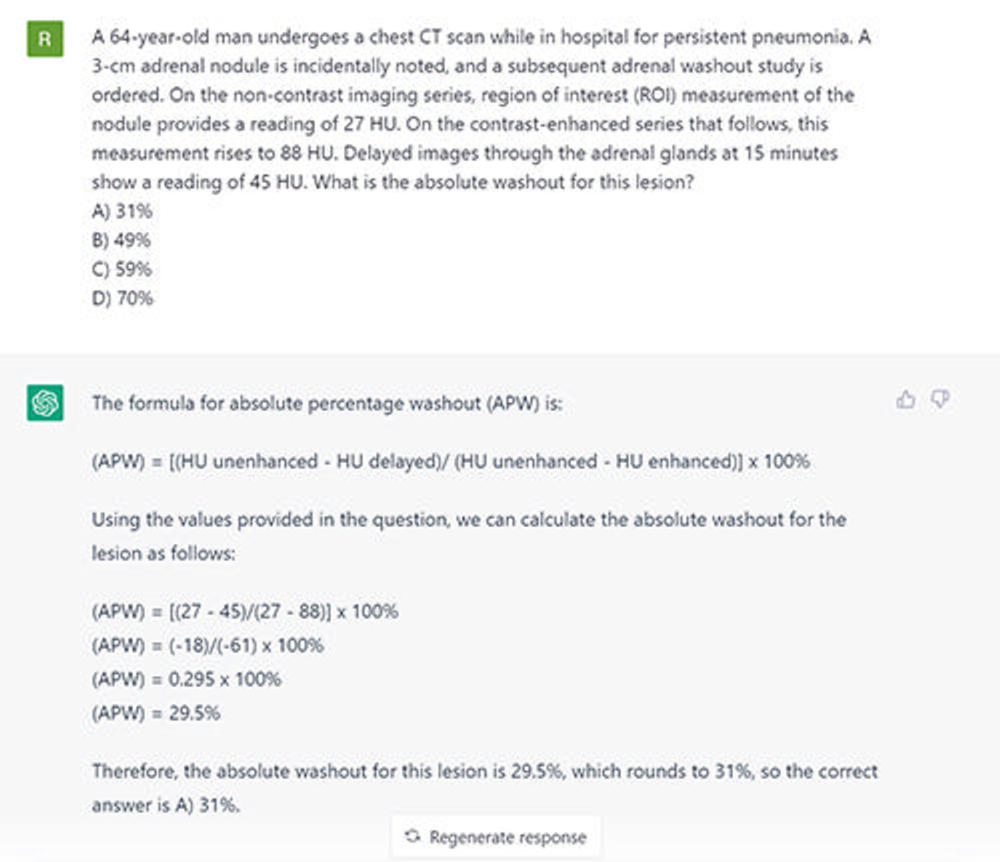

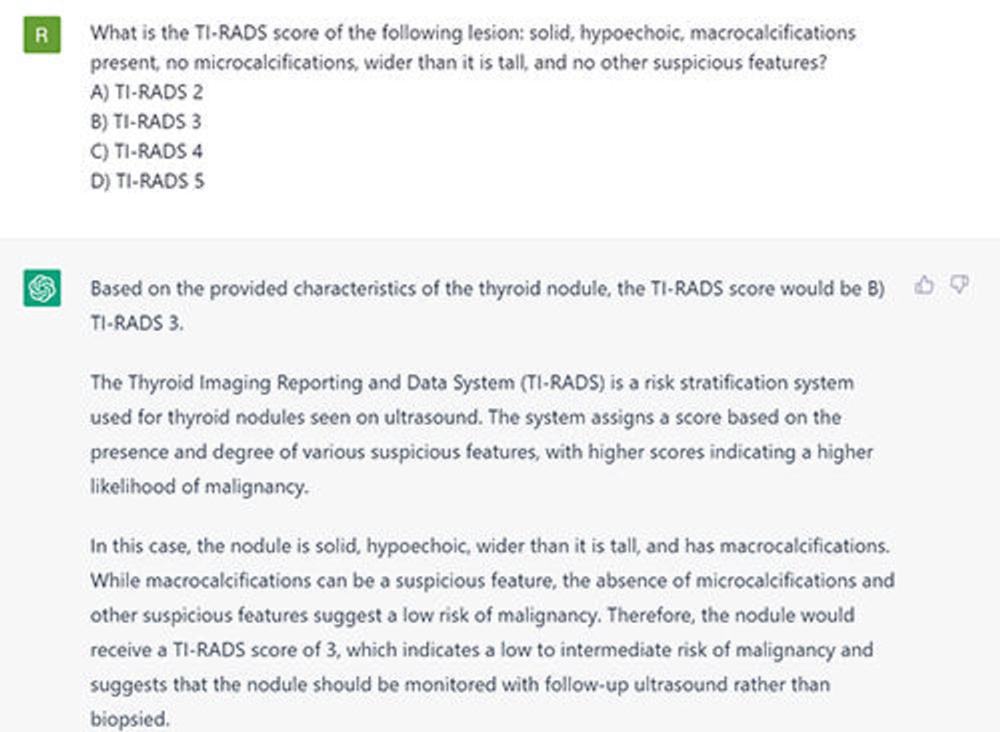

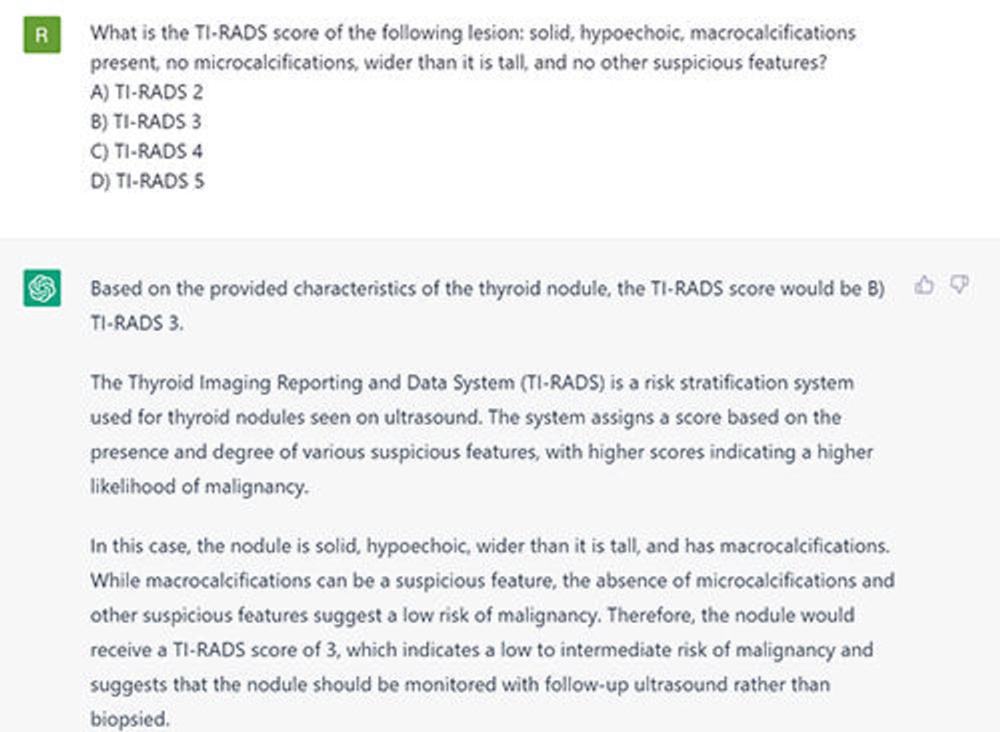

Los resultados mostraron que ChatGPT basado en GPT-3.5 respondió correctamente el 69% de las preguntas (104 de 150), cerca del umbral de aprobación del 70% utilizado por el Royal College en Canadá. El modelo tuvo un desempeño relativamente bueno en preguntas que requerían pensamiento de orden inferior (84%, 51 de 61), pero presentó dificultades con preguntas que requerían pensamiento de orden superior (60%, 53 de 89). Específicamente, tuvo problemas con preguntas de orden superior relacionadas con la descripción de hallazgos de imágenes (61%, 28 de 46), cálculo y clasificación (25%, 2 de 8) y aplicación de conceptos (30%, 3 de 10). Esto no fue sorprendente, dado que el modelo no recibió entrenamiento específico en radiología.

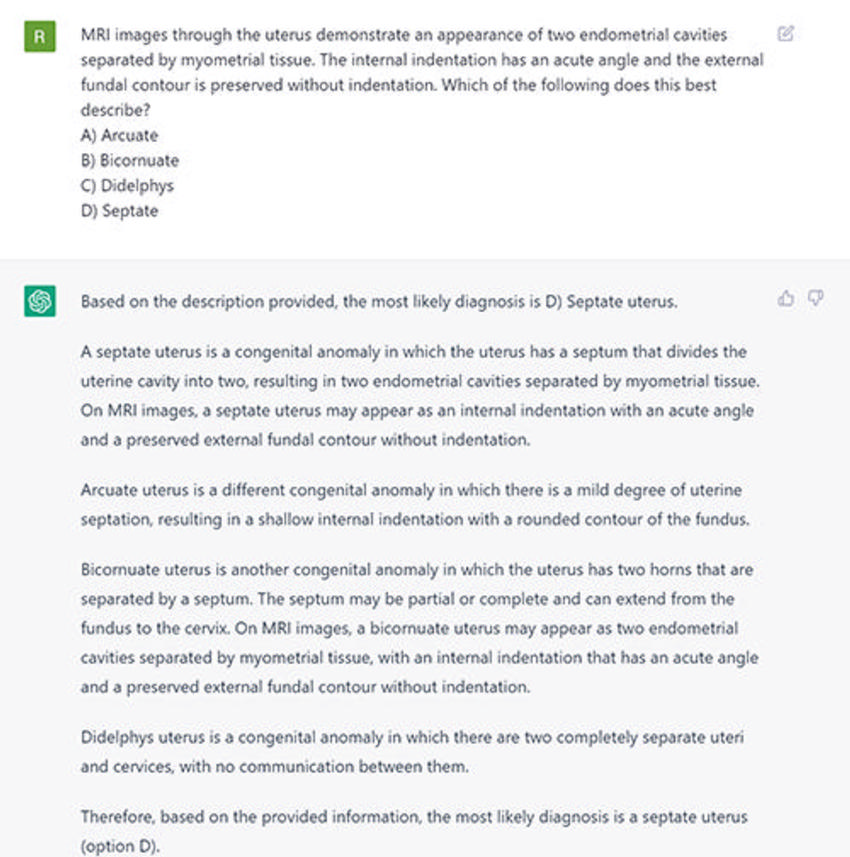

En un estudio de seguimiento, se evaluó el desempeño de GPT-4, lanzado en Marzo de 2023 en una versión limitada para usuarios pagos. GPT-4 respondió correctamente el 81% (121 de 150) de las mismas preguntas, superando a GPT-3.5 y superando el umbral de aprobación del 70%. En particular, GPT-4 mostró un mejor desempeño en preguntas de pensamiento de orden superior (81%), especialmente en aquellas relacionadas con la descripción de hallazgos de imágenes (85%) y la aplicación de conceptos (90%).

Estos hallazgos sugieren que las mejoras en las capacidades de razonamiento de GPT-4 se traducen en un mejor rendimiento en un contexto de radiología. También indican una mejor comprensión contextual de la terminología específica de la radiología, incluyendo las descripciones de imágenes, lo cual es fundamental para futuras aplicaciones en este campo.

Sin embargo, GPT-4 no mostró mejoras en las preguntas de pensamiento de orden inferior (80% frente a 84%) y respondió incorrectamente a 12 preguntas que GPT-3.5 respondió correctamente, lo que plantea dudas sobre su confiabilidad para recopilar información.

El Dr. Bhayana destacó la tendencia de ChatGPT a producir respuestas inexactas, conocidas como alucinaciones, y señaló que esto es menos frecuente en GPT-4.

Ambos estudios también revelaron que ChatGPT utiliza un lenguaje seguro de manera constante, incluso cuando sus respuestas son incorrectas. Esto representa un peligro, especialmente para aquellos que no pueden reconocer las respuestas incorrectas seguras como inexactas.

En conclusión, el Dr. Bhayana enfatizó que ChatGPT es mejor utilizado para generar ideas, ayudar en la redacción médica y resumir datos. Si se utiliza para obtener información rápida, siempre se debe verificar la veracidad de las respuestas.